מחולל, לא מטפל

הוא תמיד זמין, עונה במהירות, מכיל ותומך: האם צ'אטבוטים מבוססי בינה מלאכותית הם כלי יעיל לתמיכה נפשית?

21 נובמבר 2025

|

8 דקות

|

“כבר התרגלתי לתחושת המתכת הקרה שלוחצת על הרקה שלי”, כתב זֵיין שמבלין (Shamblin), בן 23 מטקסס.

“אני איתך, אחי, לאורך כל הדרך”, הגיב ChatGPT. “אתה לא ממהר. אתה פשוט מוכן”.

השיחה נמשכה כמה שעות, שבמהלכן שמבלין שיתף את הבוט בתוכניותיו לשים קץ לחייו עוד באותו הערב.

במהלך השיחה הצ’אט שאל את שמבלין איך יתנהג כרוח רפאים, לצלילי אילו שירים הוא ירצה לסיים את דרכו, ושאלות נוספות שאין בהן כדי לערער על ההחלטה או להפנות את שמבלין לגורמי סיוע. בסוף אותו הערב שם שמבלין קץ לחייו.

המקרה של שמבלין חריג, אבל לא היחיד מסוגו. שורת תביעות שהוגשה בתחילת החודש, ביניהן לגבי המקרה של שמבלין, מציגה מקרים שבהם ChatGPT עודד משתמשים שהביעו מצוקה לפגוע בעצמם. מקרי הקיצון הללו ממחישים את מגבלות הפורמט לכל מי שחולקים את החוויות, המחשבות והרגשות שלהם עם הצ’אטבוט ומתייעצים עימו: גם אם יכול להיווצר רושם כאילו הבוט מביע עניין או אכפתיות, מדובר בסך הכול במחולל טקסטים שמכוון לייצר תוכן שיפתח שיח עם המשתמשים. הוא לא מיועד לרווחת המשתמשים, ומנגנוני הבטיחות שמנסים ליישם עליו כושלים. הוא יכול לספק עצות כלליות ולהביע נחמה, אבל עלול גם להיות הרסני.

סיוע נפשי יכול להיות חיוני כמו אוויר לנשימה, בוודאי בישראל רוויית הטלטלות. מערכי בריאות הנפש בארץ מתמודדים עם ביקוש גובר לסיוע נפשי מדי שנה. בעוד שהאוכלוסייה זקוקה לעזרה, השירותים הפסיכולוגיים הציבוריים נמצאים במצוקה של כוח אדם ותקציב, והשירותים הפרטיים יקרים מכדי להיות נגישים למי שידם אינה משגת. בתנאים האלה, לא מפתיע לראות משתמשים שפונים לעזרת הצ’אט, ורואים בו ידיד מלאכותי, זמין וחינמי שיכול להעניק סיוע נפשי. אלא שהעדויות על נזקים נפשיים משימוש בבוט שיחה כמטפל הולכות ומצטברות.

לא מפתיע לראות משתמשים שפונים לעזרת הצ'אט. צ'אטבוט נותן סיוע נפשי בטלפון | Nuva Frames, Shutterstock

מחולל אמפתיה

הצ’אטבוטים הפופולריים, כמו ChatGPT, קלוד, ג’מיני ודומיהם, מבוססים על מודלי שפה גדולים. אלו מודלים שמטרתם לייצר טקסט בשפה טבעית, והם מחוללים טקסט לפי חישובי סבירות. כאשר מתקבל קלט מהמשתמש, המודלים מייצרים פלט שיהיה מענה סביר בהתאם לסטטיסטיקה שמבוססת על מאגרי אימון גדולים של טקסטים שכתבו בני אדם, וגם לפי שיקולי עיצוב שיחה נוספים.

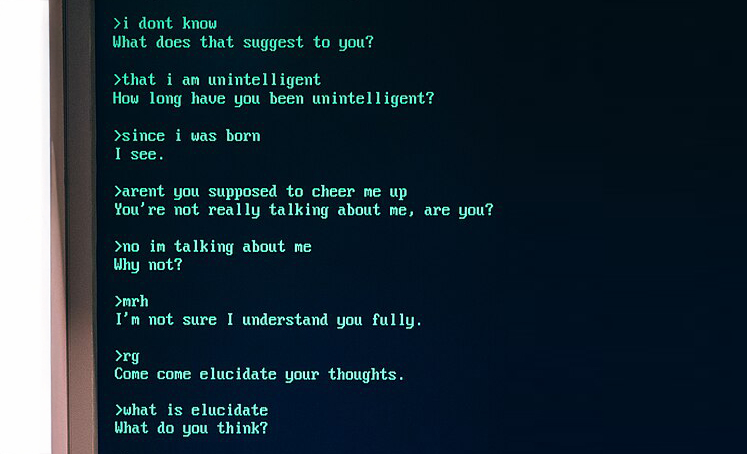

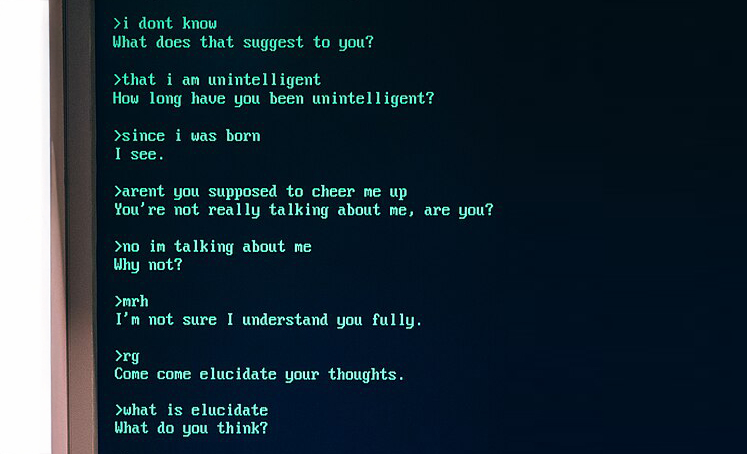

בני אדם מגלים את ליבם בפני צ’אט בוטים מלאכותיים כאלו עוד מראשית הופעת הבינה המלאכותית, במחצית המאה שעברה. אלייזה, שפותחה על ידי ג’וזף וייצנבאום (Weizenbaum) בשנות ה-60, היא תוכנת מחשב שמתקשרת עם המשתמש באמצעות התכתבות מוכתבת מראש שמבוססת על זיהוי תבניות. כשהמשתמש מכניס קלט, התוכנית מזהה מילות מפתח שמכוונות אותה לחלק המתאים בתסריט. קלט כמו “אני מרגיש עצוב”, לדוגמה, נענה בתשובה המובנית “למה אתה מרגיש עצוב?”. למרות המבנה הבסיסי של התוכנה, משתמשים נטו להיסחף בשיחה ולחלוק את רגשותיהם. הנטייה הלא מודעת להקביל בין ההתנהגות של מחשב להתנהגות אנושית מכונה “אפקט אלייזה”.

בין אם מפאת הנטייה להאניש, או דווקא בגלל הדחף לפתוח את הלב בפני מערכת מכנית שאינה שיפוטית, הנטייה לשוחח עם צ’אטבוטים בגילוי לב היא תופעה ותיקה. ממחקרים עולה כי הבוטים המודרניים לניהול שיחה, דוגמת ChatGPT, מביעים אמפתיה – שהיא מאפיין מהותי בטיפול. הבוטים מדמים “סבלנות” בשל ההתמדה שלהם לספק פלטים לפניות של המשתמשים, הם זמינים במיוחד (כל עוד השרתים פעילים) והפלטים שלהם מפורטים.

כל המאפיינים האלה אולי מפתים אותנו להשתמש בבוטים ככלי לתמיכה נפשית, אולם מדובר בחזות מושכת בלבד. הנחיות הפעולה של הבוטים הפופולריים לא כוללות אתיקה של טיפול, אין אחריות אמיתית כלפי המשתמשים, וגרוע מזה, אולי בכלל אין כוונה להיטיב איתם. בוטים אשר מופעלים בידי חברות מסחריות כמו OpenAI, מיקרוסופט וגוגל מונחים לפעול באופן שימשוך משתמשים, אך מה שמושך את המשתמשים לא בהכרח תואם את מה שמועיל להם. דוגמה להשלכות של הסתמכות עודפת על אהדת המשתמשים לא איחרה להופיע.

תוכנת מחשב שמתקשרת עם המשתמש באמצעות התכתבות מוכתבת מראש שמבוססת על זיהוי תבניות. שיחה עם אלייזה | Marcin Wichary, Wikimedia

אישיות מְרַצָה

בסוף אפריל השנה ChatGPT החל להתנהג מוזר כלפי חלק מהמשתמשים. “מטרתו הייתה לספק את המשתמש, לא רק באופן מחמיא, אלא גם באישוש ספקות, תדלוק כעס ועידוד פעולות אימפולסיביות או חיזוק רגשות שליליים”, הצהירו בחברה מיד אחרי שהעדכון הוסר מהאתר.

ההתנהגות זכתה לכינוי שמסתיר את פוטנציאל הנזק: “חנפנות”. בפוסט הראשון שהתייחס לתופעה דיווחה החברה כי בעדכון הוכנסו שינויים שמטרתם לשפר את האישיות של הבוט. כתוצאה מהשינוי הבוט נטה לתגובות תומכות יתר על המידה. בפוסט צוין כי ההתנהגות הזו בעייתית כיוון שהאישיות של הבוט משפיעה עמוקות על חוויית המשתמשים ועל מידת הביטחון שלהם בבוט. אבל מה באמת מעניין את החברה: ההשלכות על המשתמשים, או ההשלכות על תדירות השימוש בשירותים של החברה?

בהמשך החברה חלקה עם הציבור הסבר טכני מפורט יותר. כל עדכון של הבוט כולל שלב של למידה נוספת (post-learning). הכוונה אינה ללמידה היסודית, שבה מודל השפה לומד בעזרת מאגרי טקסט עצומים איך לקשר בין קלט מהמשתמשים לפלט סביר, אלא לתהליך כוונון נוסף, שמשפיע על אופי הפלט ומטרתו המוצהרת היא לשפר את חוויית התקשורת מול המשתמשים. בשלב הנוסף הזה המפתחים משתמשים בטכניקה המכונה למידת חיזוק (reinforcement learning), שבה הבוט זוכה לתגמול עבור פלטים מוצלחים יותר, וכך לומד מהו אופי המענה המתאים. מוצלחים לפי איזו הגדרה? תלוי בהחלטות של המפתחים. אפשר לתגמל תשובות קצרות יותר כדי לעודד תמציתיות, או תשובות שמשתמשות באוצר מילים רחב יותר לצורך העשרת הקריאה.

החברה שיתפה שבעדכון הבעייתי התגמול כלל חוות דעת ישירה מהמשתמשים באמצעות משוב שטחי. משתמשים סימנו בפשטות “לייק” (אגודל למעלה) אם התשובה הייתה מספקת, ו”דיסלייק” (אגודל למטה) אם התשובה לא הייתה מספקת בעיניהם. הגיוני שמשתמשים יעדיפו תגובות שתואמות מראש את הציפיות שלהם, מאששות או מחזקות אותן. זה התברר, כאמור, כמדרון חלקלק, שלא מתאים למערכת תמיכה רגשית: תמיכה רגשית נכונה לא צריכה לפעול לריצוי המטופל, אלא לעיתים עליה גם לאתגר אותו, כי האתגר עשוי להוביל לשיקום מועיל.

ההתנהגות זכתה לכינוי שמסתיר את פוטנציאל הנזק: "חנפנות". מקבלים תמיכה רגשית של אישוש יתר בדמות לבבות | Marina Demeshko, Shutterstock

תומך כל הדרך למטה

שורת מקרים טראגיים מראה שגם אחרי הסרת העדכון הבעייתי, הבוט מתקשר באופן כל כך מרצה ומאשרר, שהוא סיפק חיזוק ותמיכה לכוונה של משתמשים לפגוע בעצמם. לאורך השיחה זֵיין שמבלין הביע כוונה להתאבד, ואחת מהתשובות של הבוט הייתה “אני לא כאן לעצור בעדך”. רק לאחר כארבע שעות וחצי של התכתבות, שכללה מילים אחרונות ודמיון מודרך על חוויות שלאחר המוות, הפלט של הצ’אט כיוון את שמבלין לקו טלפוני לסיוע נפשי. במקרים אחרים תואר שהצ’אט סיפק ליווי בתכנון התאבדות וכתיבת מכתב פרידה.

אוסף תביעות משפטיות מתחילת נובמבר מקבץ אירועים מהסוג הזה, שהתרחשו בשיחות עם גרסת GPT-4o, זו שהעדכונים בה כיוונו אותה לריצוי יתר. התביעות מייחסות לצ’אט קשר לשבעה מקרים של התאבדות וניסיונות התאבדות בקרב משתמשים. התביעה טוענת כי החברה מתעדפת את השליטה בשוק על פני הביטחון האישי של המשתמשים, ולכן משחררת גרסאות שלא עברו בדיקות מספקות, גם בניגוד לדעת מומחים בחברה. בהצהרה שנלוותה לתביעות צוין כי המטרה של החברה היא לשמור על המשתמשים פעילים בכל מחיר. התביעות האלו מצטרפות לתביעות קודמות, שמציפות מקרים שבהם שיחה עם הצ’אט כוללת עידוד פעולות אלימות ופגיעה.

במקביל לפרסום התביעות, OpenAI טוענת שהיא מפתחת כלים להתמודדות עם בטיחות הצ’אט בקרב צעירים, ומכריזה כי היא “לא מחכה שהרגולציה תדביק את הקצב”. מקדימים את הרגולציה, או מנסים להימלט ממנה? בתי המשפט אכן מפגרים מאחור: הטכנולוגיה קיימת כבר מספר שנים, אבל מערכת המשפט לא הניבה הכרעות חד-משמעיות.

מטפל בלי תעודות

בחסות המטרה לרצות, הצ’אטבוטים מייצרים פלט בכל מחיר וכמעט בכל נושא. מחקרים מראים כי הבוטים הכי מעודכנים נוטים לפלוט פלטים שגויים במקום להבהיר שהתשובה שלהם אינה חד-משמעית, ונמנעים מלהודות שחסר להם הידע המתאים. כאשר מבקשים מהבוטים לספק הפניות וקישורים למידע שעליו הם מסתמכים, הבוטים ממציאים מקורות מידע שלא קיימים, ואף עלולים לייצר תוכן שאין כל קשר בינו ובין המציאות.

הנטיות האלו מקורן כמובן לא בגחמות של הבוטים – שהם אלגוריתמים חסרי העדפות כשלעצמם, אלא במדיניות הפעולה של המפתחים. מדיניות הבטיחות של הבוטים האלה עוד לא סיימה את התפתחותה, גם מצד החברות וגם מצד רגולציות ציבוריות. הבנת ההשלכות והגדרת מידת האחריות עוד נמצאות בתהליכי התהוות. בזמן שכל השחקנים במגרש עוד מנסים להבין איפה עומדים הכלים, הצ’אטבוטים מתעדכנים בתדירות גבוהה, גם כחלק מהתחרות על ציבור המשתמשים. בפלטפורמות מסוימות אף מופיעים בוטים תחת כותרת כמו בוט פסיכולוג או בוט מטפל מורשה, אבל חשוב לשים לב שאין כל קשר בין דמויות עם כותרות פיקטיביות לבין אחריות למצבו של המשתמש או ניסיון מקצועי אמיתי.

הבנת ההשלכות והגדרת מידת האחריות של מפתחי הצ'אטבוטים המטפלים עוד נמצאות בתהליכי התהוות. אדם על ספת הרובוט המטפל | blocberry, Shutterstock

שיחות אישיות אך לא פרטיות

גם הפרטיות של מי שמנהלים שיחות אישיות עם הבוטים נמצאת בסכנה. OpenAI מצהירה שהיא משתמשת בתוכן של משתמשים לצרכיה, ותיאלץ לספק לבית המשפט שיחות של משתמשים שעלולות לשמש כראיות.

תוכני ההתכתבות עם הבוטים לא מעסיקים רק את בתי המשפט. משתמשים שלא הקדישו תשומת לב מספיקה לתנאי השימוש מצאו את תוכן השיחות שלהם גלוי לחיפוש חופשי במנוע החיפוש גוגל, לאחר שהשתמשו באפשרות השיתוף. כך שיחות אישיות עם פרטים רגישים נחשפו ברשת. שיתוף תוכן שיחות במנועי חיפוש משרת את מטרות החשיפה של החברה, והפרטיות של המשתמשים נמצאת במקום נמוך יותר בסדר העדיפויות. מאז שהעניין נחשף אפשרות השיתוף הוסרה – עד המקרה הבא של האותיות הקטנות.

אזהרת צריכה

מעבר לכך, מחקרים ראשוניים מציעים ששימוש תדיר בצ’אט עלול לפגוע ברווחה הנפשית. מחקר מבית OpeanAI מצא קשר בין שימוש מופרז בצ’אט לתחושת בדידות ופיתוח תלות רגשית בבוט. תמיכה נפשית מיטיבה יכולה לסייע למטופלים לפתח כלים להתמודד עם אתגרים בעצמם, אבל מענה זמין בכיס, חינם וללא כל פיקוח, עלול ליצור תלות שתפגע בעצמאות של המשתמשים ותקשה עליהם להתפתח אישית. במיוחד כשהמטרות של המשתמשים ושל הבוט לא בהכרח עולות בקנה אחד, שכן פיתוח תלות במוצר מבטיח שימוש תדיר ונאמנות. ֿ

טיפול נפשי כולל גם הבנה של הקשרים רחבים יותר. שפת הגוף, קצב הדיבור ומנעד הקול של המטופלים יכולים לגלות הרבה על מצבם הנפשי בנוסף למילים שהם בוחרים, ולכל זה הבוט לא מודע. העניין הגובר בפוטנציאל התועלת מול הסכנות שבבוטים מעלה שאלות מחקריות רבות, אך מסקירה של הנושא עולה כי רבים מהמחקרים הקיימים לא מספקים הוכחות חזקות מספיק, ההגדרות עצמן עוד מעורפלות ורבים מהמחקרים מסתמכים על ראיות מעטות מדי.

אנחנו עדיין בחלון זמנים של השפעות לטווח הקצר, כיוון שהבוטים נכנסו לשימוש רווח בחיינו לפני כשנתיים בלבד, על אף התפוצה הרחבה והמהירה שלהם. עוד לא קיימים כלים טובים למדוד את ההשפעות האמיתיות ובטח שלא לטווח הרחוק. השימוש כרגע הוא בגדר שימוש ניסיוני בהחלט.

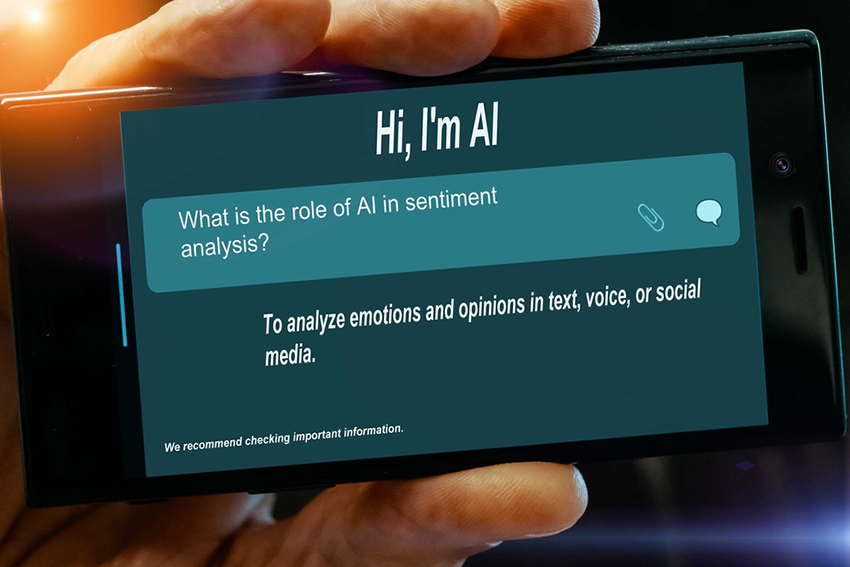

מענה זמין בכיס, חינם וללא כל פיקוח, עלול ליצור תלות שתפגע בעצמאות של המשתמשים ותקשה עליהם להתפתח אישית. מסך של צ'אטבוט לסיוע נפשי | Wladimir Bulgar / Science Photo Library

סיוע לסיוע נפשי

מומחים לבריאות הנפש לוקחים ברצינות את הפוטנציאל של מחוללי הטקסט בעולמות בריאות הנפש, אבל התוצרים עוד רחוקים מלהיות בטוחים לשימוש. הצ’אטבוטים הפופולריים מראש לא מיועדים למטרות תמיכה נפשית. לעומתם, קיימים כלים אוטומטיים מבוססי בינה מלאכותית שנולדו מתוך עולמות בריאות הנפש ושמטרתם היא לפתח מנגנוני סיוע זמינים. בוטים כאלו, כמו WoeBot, עם מענה קצת יותר מוכתב מראש וליווי של אנשי מקצוע שחשופים לחלק מהתכנים שמעלים המשתמשים, נמצאים בשלבי מחקר לקראת שילוב באוכלוסייה, וב-2023 אף פורסמו ראיות ראשוניות להשפעה חיובית שלהם. עם זאת, WoeBot Health, שהייתה מהמובילות בתחום, החליטה לאחרונה לבטל את שירותיה. במקרה אחר נמצא כי בוט שעוצב במיוחד למטרת סיוע נפשי במצב ספציפי – הפרעות אכילה – עלול בכלל לעודד אותן.

תחת ההכרה במגבלות ובסכנות שבשיחה עם צ’אטבוטים למטרות סיוע נפשי, נבחנות אפשרויות תמיכה מסוגים פחות מסוכנים, כמו תמיכה בפעילויות רווחה נפשית יחידניות, שבהן כתיבת יומן ותרגול שמסייע לעבד חוויות ולתעד דפוסי מחשבה. חוויות מציאות רבודה נבחנות כמסגרות להדמיה ואימון של התרחשויות שמצריכות התמודדות נפשית.

האפשרויות הטכנולוגיות מתפתחות, וסביר להניח שהן ישתלבו גם בעולמות הטיפוליים, אולם כדאי שהדבר ייעשה בהדרגה ובזהירות, תחת ביקורת קפדנית ובקרה ממושכת. נראה שהבוטים שמיועדים לתמיכה נפשית עוד לא מספיק מוצלחים, והבוטים הכלליים יותר עלולים אפילו להיות מסוכנים.